A revista circula, primordialmente, no impresso, mas combinei, com uma das editoras, que iria circular aqui versões em inglês (o original, pois, infelizmente, apenas consigo ler em alemão – e bem mal, hoje em dia) e português (tradução apressada, como sempre).

Digital technologies in Brazil: Metaphors we live by, but would prefer not to.

Leader: Ideas surrounding digital technologies in Brazil are often expressed in terms of metaphors that are imported and translated from the Anglophone world. Metaphors, however, are not mere figures of speech, but cognitve devices that create worlds and subjects to inhabit them. This article suggests that technology-related metaphors sustain Modernity’s rationale of progress through control, supporting the country´s (re)colonisation, now via digital means.

Main text

A perfect storm appears to be brewing in Brazil. Whilst an extreme right-wing government unashamedly rewrites history, daily feeding its mob of supporters with countless absurdities, control of national oil reserves and other exploits from the land is quietly given away to multilateral interest groups, with no concern for the environment, nor any real gain for the common citizen. Also traded away with a borderless industry is all the data created daily in internet-based transactions, from ordinary activities like grocery shopping to the exchanges of personal information on social networks and learning platforms that have become, undoubtedly, lifelines during the covid-19 pandemic. As the pandemic rages on in the country, fuelled by denialism, cynicism and other manners of violence, data is fast becoming the new oil, to use its (arguably) most common conception as a metaphor in circulation in the Anglophone world.

But what does it mean, to have a metaphor as a form of conceiving something?

Common-sense understandings of metaphor tend to be, to a large extent, dismissive, even cavalier: mere figures of speech, embellishments, at best, perhaps obfuscating devices, in some academic circles. To illustrate the reductionist character of these perspectives, let´s take an example that remains in use even as it is (or should be) appalling to women: dolls as a vocative.

Dolls have traditionally played a key role in child development across cultures. Highjacked by the capitalist order, however, they eventually came to function as aesthetic models. Despite recent attempts of the toy industry to represent diversity in the abstract sorts of prettiness they (re)present, dolls have come to personify ideals that, in the extreme, support terrible forms of self-mutilation. They are lifeless bodies that sit quietly in a corner until dragged into role playing to scripts created by others. They are animated, managed and manoeuvred by others. They speak with the voices of others. Doll-women have no minds of their own: they exist to articulate, channel, and serve the desires of others.

This example illustrates that metaphors are much more than figures of speech. Metaphors outline specific ways of being, existing and acting in the world. Whilst expressed in language, they possess a physical base and point to materiality: as ways of conceiving things, they outline possibilities and limits to what these things may be, how they are supposed to behave, what they are allowed to do and say. In this sense, metaphors condense specific worldviews, shedding light on certain aspects of existence whilst obscuring others and, thus, embodying ideology.

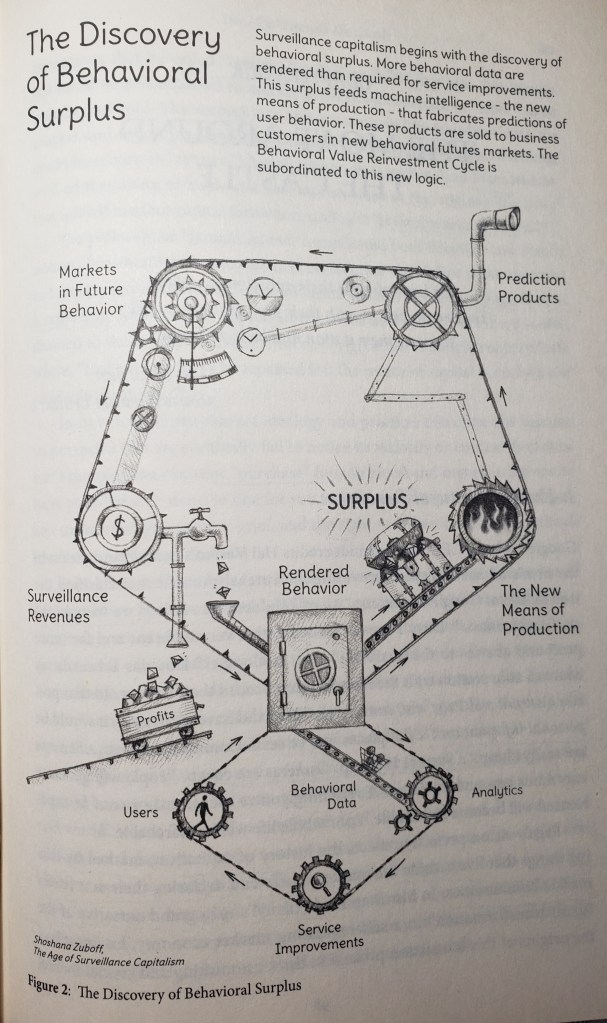

As women-dolls are creatures destined to a mode of being devoid of agency, data-as-the-new-oil is fated to be a very lucrative commodity, although, as usual, not really to those who effectively produce it.

In this vein, it is not surprising that this is not the most common metaphor of data to be found in Brazilian talk and writing. In my research on how digital educational technologies are being conceived in the country, three other more general metaphors have emerged: data as a natural resource; data as a tool; data as a subject. Talk and writing about data claims that raw data is captured, collected and extracted, prior to being treated and processed in operations such as grouping, cross-referencing and, interestingly, welding. Eventually, data is transferred, stored and exploited, deposited in databases or databanks. Data also helps, supports, facilitates, i.e., personifies a guide that measures, assesses, predicts, and encourages desirable behaviours.

Some claims associated with data and, more generally, digital technologies push us towards the realm of fantasy: Artificial Intelligence (AI), for example, is equated with a powerful precog, a soothsayer who can foretell the future. Data-driven AI becomes an entity with predictive abilities due to an assumed capacity to find meaning in large volumes of data that cannot be processed by human beings. In this way, data-driven technologies are framed not only as subjects but, more specifically, as better subjects, since data is supposedly objective (unbiased), encompassing (omniscient) and precise. Data is thought of as an immaterial being who knows us better than we do ourselves.

However, it is unproductive to talk about the digital world as immaterial, as some commentators insist on doing, considering that their effects in the world are anything but immaterial. In Brazil, the ongoing pandemic has unleashed a huge increase in the adoption, by all sectors and levels of education, for example, of services provided by the ‘Big 5’ (GAFAM – Google, Amazon, Facebook, Apple and Microsoft). Training and other types of support activities have already begun to grow into a profitable trade surrounding this uptake, but little is said in terms of what is effectively being done with all the data generated, how privacy and security may be guaranteed to teachers, students, and their families, and, crucially, how pedagogy is or may be affected by imported standards and their associated practices. Educationalists worry about the sorts of human beings who will emerge from this digital assembly line supported on (and, perhaps more importantly, supportive of) a cross-national infrastructure that escapes all jurisdictions.

To a large extent, technology-related metaphors in Brazil are translations and (mal)adaptations, primarily imports from the Anglophone world made via the industry that produces them. We are thus colonised by a rhetoric that is beset with self-fulfilling prophecies epitomising technological solutionism: the idea that technology will provide the solution to all human problems – although some humans are more equal than others in matters of distribution and access. Like most digital technologies, technologies that trade in data are also tediously marketed as tools, perhaps the most common, albeit unfortunate, manner of conceiving them and defending their assumed usefulness: this is yet another metaphor that conveniently obscures the various types of biases inscribed in these objects throughout their processes of design, manufacture and marketing.

In contemporary Brazil, all of this takes place within an environment of expanding fundamentalism that pays little attention to pre-existing inequalities – digital and otherwise. Hard-won victories on issues related to gender, sexuality and treatment of all manners of minorities are gradually unravelled by a destructive government that supports a local ‘Aunt Lydia’ as the Minister of Women, Families and Human Rights. In this dystopian scenario, despite the lesson taught by the pandemic on the key role of teachers and what they do, home-schooling is now the ‘apple in the eye’ of a powerful elite that gazes covetously at those naively searching for tools to sort out their differences with a battered public education system.

Big data and AI are, in fact, only the latest in a long succession of technological fads, their metaphors consistent with a much older underlying logic: the idea of progress through science and technology that supports the Faustian project of Modernity. In defending the power of science to model and predict, as well as the potential of technology to be harnessed and transformed into solutions to problems, this is a logic that entails a certain type of relationship with nature: nature as something to be tamed, mastered and, ultimately, exploited. This rationale permeates other manners of relations – between people, between classes, between nations – historically associated, through a common genealogy, with a logic of control. All of these metaphors thus compose a conceptual backdrop shared by imperialism, colonialism and, more generally, patriarchy, and can hardly escape supporting subjugation and servitude.

Political life in Brazil appears to be purposefully driving the country back to its original status as an exploitation colony, with data positioned as perhaps one of its most sought-after commodities in emerging digital geopolitics. We are two decades into this century, yet representation of Brazil´s diversity remains poor. To be sure, we have made some strides towards remedying, in particular, women’s representation. However, although we recognise the value of increasing rates of female students in STEM and business or politics, we are confronted with rising numbers of femicides whilst watching media promotion of anthropomorphic female robots, embodiments of a chauvinistic industry.

Identifying and reflecting upon the metaphors that construct our world may be a way forward and away from the logic of oppression that supports Modernity’s technological enterprise. Goethe’s Gretchen declined the invitation to play the supporting role of a doll in Faust’s (mis)adventure, but, in remaining true to what was dear to her, her refusal costed her life. As the Faustian drama continues to unfold, albeit now with a digital façade, we need new metaphors and optional paths for Gretchen and all of those in positions of subservience. Perhaps alternatives may emerge from localised reflection and action in the midst of a brewing storm.

Comment: ‘Aunt Lydia’ is a character is Margaret Atwood’s The Handmaid’s Tale, a piece of dystopian future that portrays a world where young and fertile women of popular classes have been reduced to breeders after a ‘revolution’ that established as norm some of the cruellest patriarchal practices.

Bibliography

Berman, Marshall (1982). All that is solid melts into air. The experience of modernity. New York; London: Penguin.

Ferreira, Giselle M.S. et al. (2020). Metaphors we’re colonised by? The case of data-driven educational technologies in Brazil. Learning, Media and Technology 45(1) pp. 46-60. Available at: https://doi.org/10.1080/17439884.2019.1666872.

Lakoff, George & Johnson, Mark. (1980) Metaphors we live by. Chicago: University of Chicago Press.